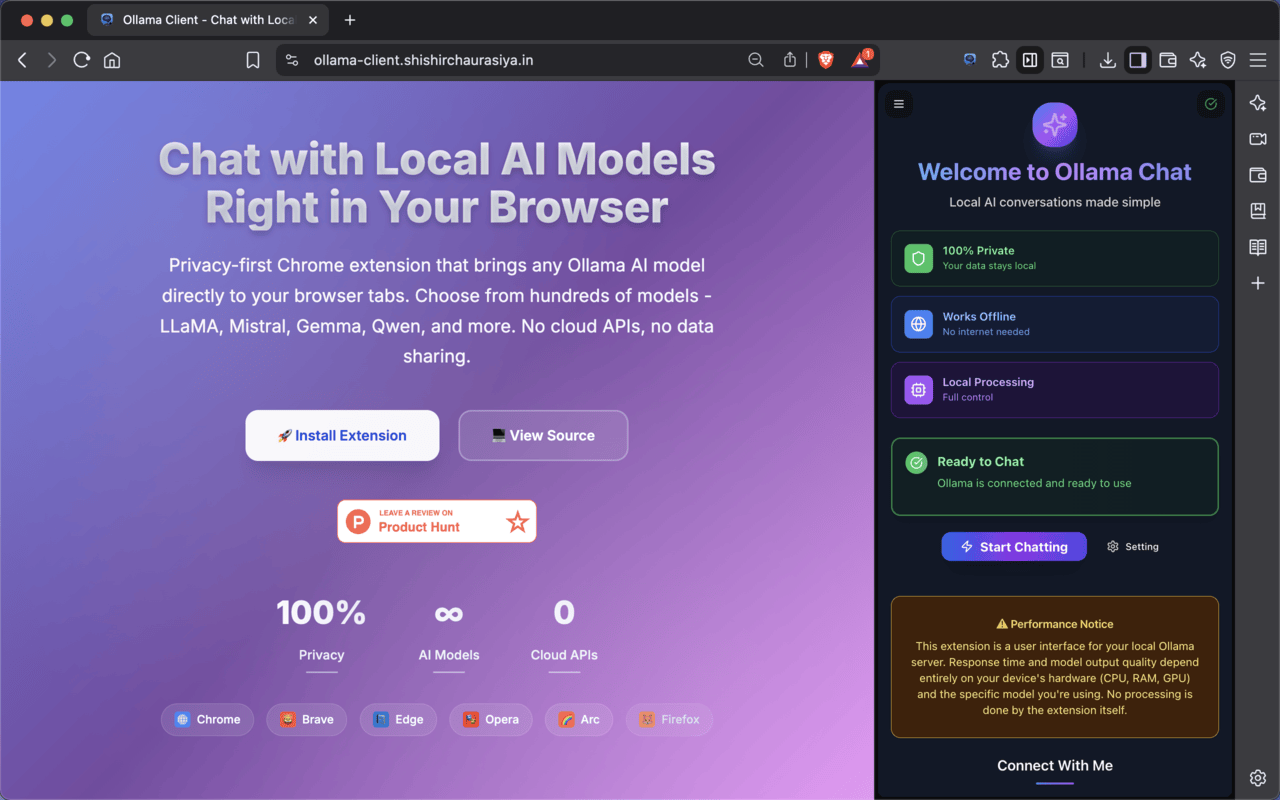

Ollama Client - Chat with Local LLM Models

插件介绍

隐私优先的 Ollama Chrome 扩展程序,可与 LLaMA、Mistral、Gemma 等本地 AI 模型聊天 - 完全离线。

🧠 Ollama 客户端 – 在浏览器内与本地法学硕士聊天

Ollama Client 是一款轻量级、隐私优先的 Ollama Chrome 扩展程序,可将本地 AI 模型和离线 AI 聊天的强大功能直接带到您的浏览器中。没有云依赖。没有 API 密钥。没有数据发送到外部。

快速、安全、Ollama 浏览器扩展支持的离线 AI 聊天,由 LLaMA 3、GPT-OSS、Mistral、Gemma、CodeLLaMA 等开源模型提供支持 - 所有这些都使用 Ollama 后端在您自己的计算机上运行。

✨ 适用于所有基于 Chromium 的浏览器(Chrome、Edge、Brave)和 Firefox(需要额外设置)。 100% 开源。

🚀 主要特点

🤖 模型管理

🔌 本地 Ollama 集成 – 连接到本地 Ollama 服务器(无需 API 密钥)

🌐 LAN/本地网络支持 – 使用 IP 地址连接到本地网络上的 Ollama 服务器(例如,http://192.168.xx:11434)

🔄 模型切换器 – 通过漂亮的 UI 在模型之间实时切换

🔍 模型搜索和拉取 – 在 UI 中直接从 Ollama.com 搜索和拉取模型(带有进度指示器)

🗑️ 模型删除 – 使用确认对话框清理未使用的模型

🧳 加载/卸载模型 – 有效管理 Ollama 内存占用

📦 模型版本显示 – 轻松查看和比较模型版本

🎛️ 高级参数调整 – 每个模型配置:温度、top_k、top_p、重复惩罚、停止序列、系统提示

💬 聊天和对话

💬 美丽的聊天 UI – 使用 Shadcn UI 构建的现代、精美的界面

🗂️ 多聊天会话 – 创建、管理和在多个聊天会话之间切换

📤 导出聊天会话 – 将单个或所有聊天会话导出为 PDF 或 JSON

📥 导入聊天会话 – 从 JSON 文件导入单个或多个聊天会话

📋 复制和重新生成 – 快速重新运行或复制 AI 响应

⚡ 流媒体响应 – 带输入指示器的实时流媒体

🆕 v0.3.2 中的新增功能:选择聊天

右键单击所选文本→“询问 Ollama 客户”

光标附近可选的浮动按钮

智能附加到输入框而不覆盖现有文本

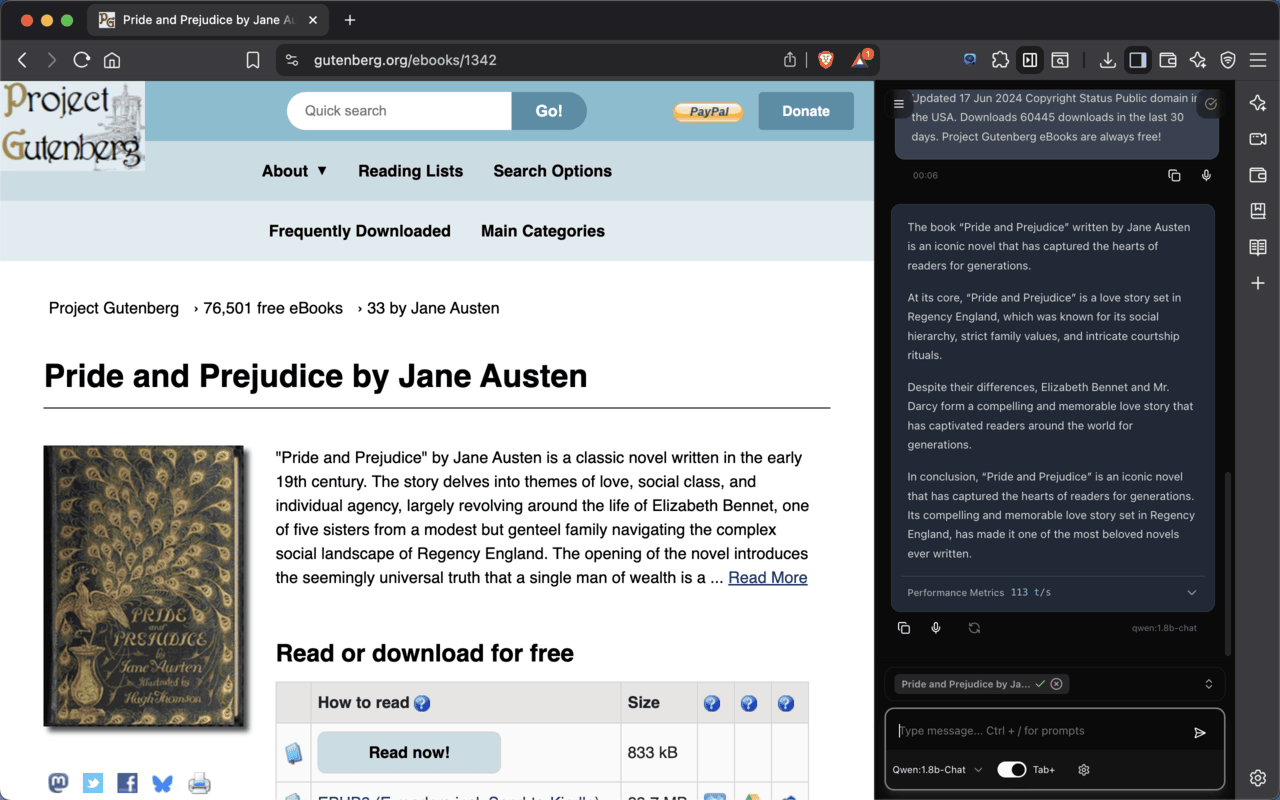

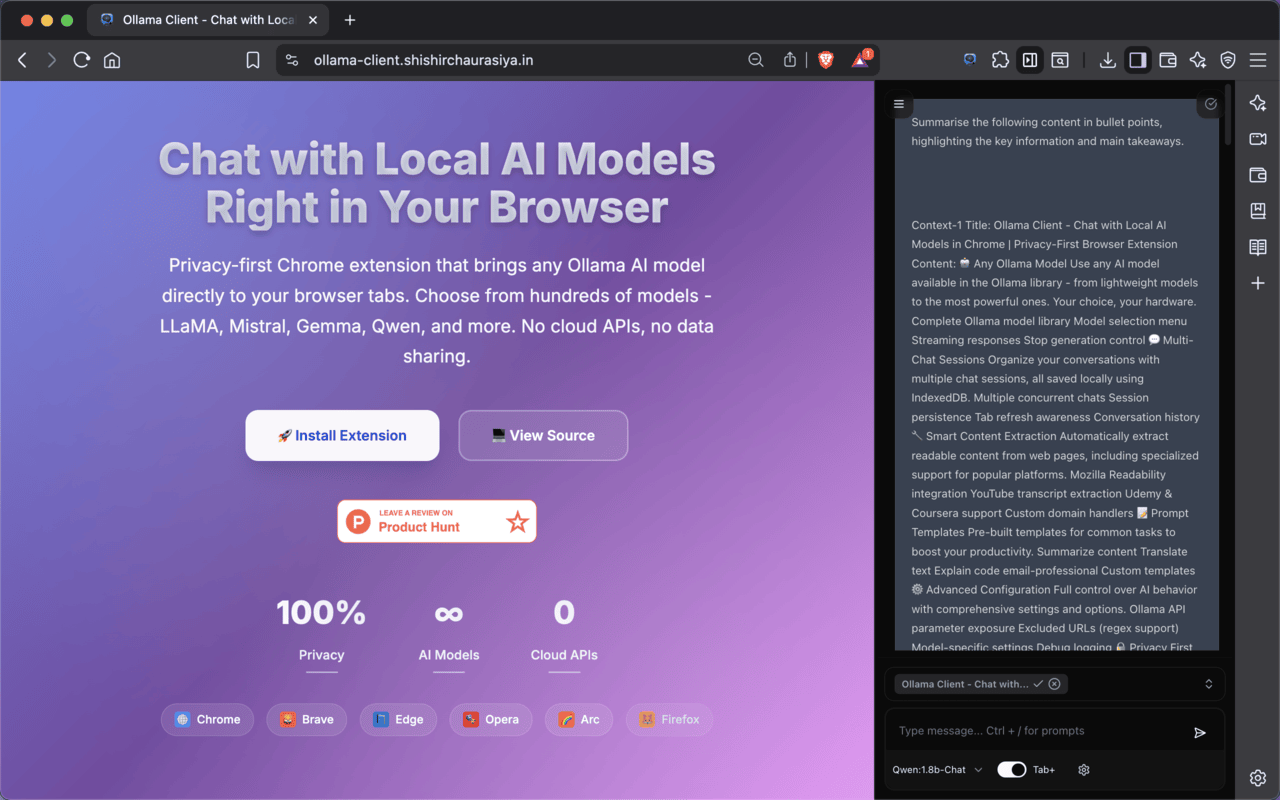

🌐 网页整合

🧠 增强的内容提取 – 具有多种滚动策略的高级提取(无、即时、渐进、智能)

🔄 延迟加载支持 – 自动等待动态内容加载

📄 特定于站点的覆盖 – 配置每个域的提取设置(滚动策略、延迟、超时)

🎯 Defuddle 集成 – 具有 Defuddle 后备功能的智能内容提取

📖 Mozilla Readability – 使用 Mozilla Readability 进行回退提取

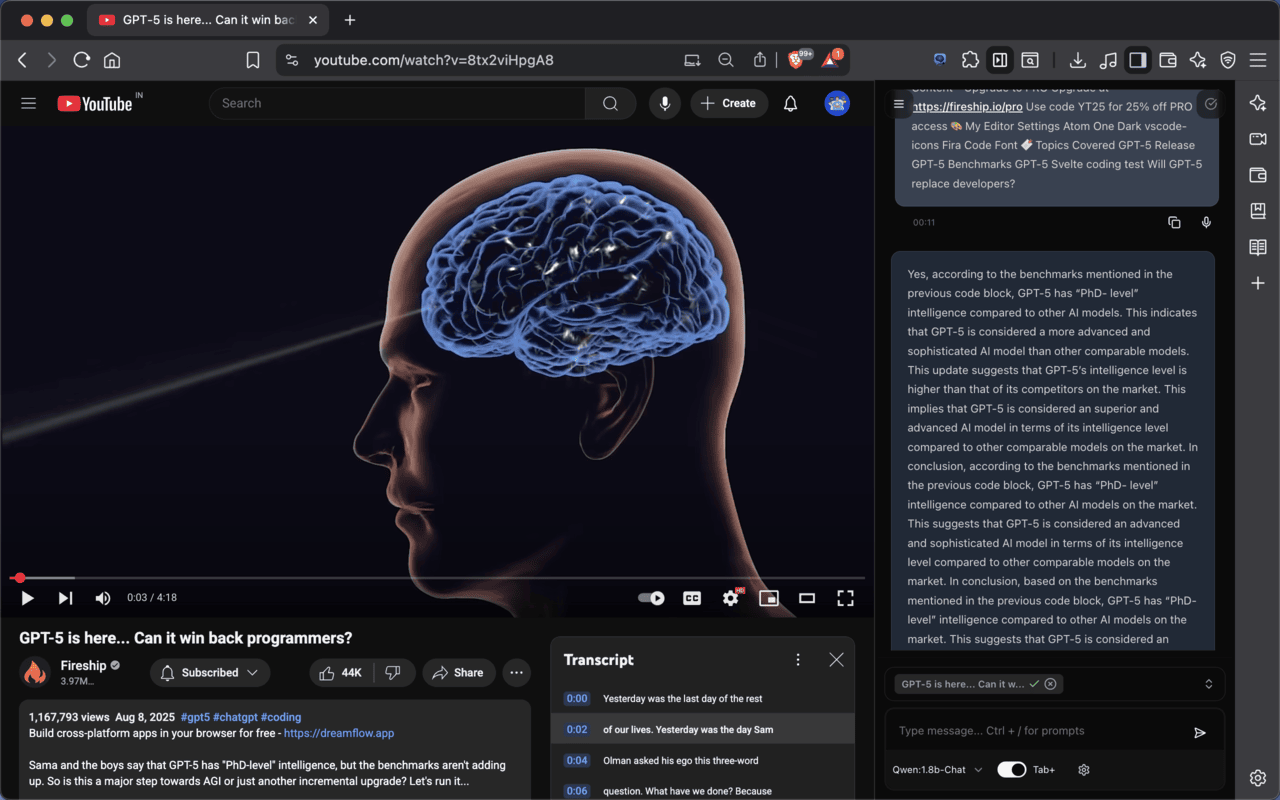

🎬 YouTube 成绩单 – 自动提取 YouTube 成绩单

📊 提取指标 – 查看滚动步骤、检测到的突变和内容长度

📁 文件上传和 RAG(测试版)— v0.3.2 中的新增功能

上传 PDF、TXT、Markdown 和图像

自动智能分块

使用向量嵌入的 RAG 驱动的上下文答案

实时嵌入/模型进度指示器

🔍 语义搜索(Beta)——v0.3.2 中的新增功能

基于矢量的文件+聊天记录搜索

具有相似度分数的专用搜索对话框

⚙️ 自定义和设置

🎨 专业 UI – 现代设计系统,具有玻璃态效果、渐变和流畅的动画

🌓 深色模式 – 美丽的深色主题,过渡平滑

📝 提示模板 – 创建、管理和使用自定义提示模板 (Ctrl+/)

🔊 高级文本转语音 – 可搜索的语音选择器,可调节语速和音调

🎚️ 跨浏览器兼容性 – 适用于 Chrome、Brave、Edge、Opera、Vivaldi、LibreWolf 等

🧪 语音测试 – 使用前测试语音

🔒 隐私和性能

🛡️ 100% 本地和私有 – 所有存储和推理都发生在您的设备上

🧯 声明式网络请求 (DNR) – 自动 CORS 处理

💾 IndexedDB Storage – 用于聊天会话的高效本地存储

⚡ 性能优化 – 延迟加载、去抖动操作、优化重新渲染

🔄 状态管理 – 基于 Clean Zustand 的状态管理

🧭 选项卡访问(可选)

希望您的法学硕士了解您正在查看的页面的内容吗?在设置中启用选项卡访问以获取页面内容或文字记录以获得更好的上下文答案。

✔️ 完全选择加入

✔️ 您选择要共享的标签

✔️ 可定制的排除列表(支持正则表达式)

✔️ 任何标签数据都不会离开您的设备

⚙️ 安装和设置

1️⃣ 从 Chrome 网上应用店安装 Ollama 客户端

2️⃣ 从 https://ollama.com 在您的计算机上安装 Ollama 并运行 `ollamaserve`

3️⃣ 拉出你最喜欢的模型(例如`ollama pull llama3:8b`、`gemma:2b`)并开始聊天!

高级用户可以从“选项”页面自定义主题、模型参数、提示模板和排除的 URL。

🎯 谁应该使用 Ollama 客户端?

👩💻 使用 LLM 进行构建或调试的开发人员

📚 想要本地、私人 LLM 接口的研究人员

🎓 学生在本地硬件上使用人工智能作为学习辅助工具

🔐 隐私倡导者避免使用云人工智能和 API

🤖 AI 修补者和开源模型爱好者

⚡ 性能和硬件建议

💻 8 GB RAM(无 GPU):gemma:2b,mistral:7b-q4

💻 16 GB RAM(无 GPU):gemma:3b-q4、gemma:2b

🚀 16 GB+ 带 GPU(6GB VRAM):llama3:8b-q4,gemma:3b

💥 32 GB+ 或高端 GPU:llama3:8b、codellama:13b

🔥 RTX 3090+、Apple M3 Max:llama3:70b、mixtral

注意:Ollama Client Chrome 扩展只是一个前端界面。所有 LLM 生成都是通过本地 Ollama 安装进行的。速度和输出取决于您的系统。

🔗 有用的链接

🌐 Chrome 网上应用店:https://chromewebstore.google.com/detail/ollama-client/bfaoaaogfcgomkjfbmfepbiijmciinjl

📘 设置指南:https://ollama-client.shishirchaurasiya.in/ollama-setup-guide

💻 登陆页面:https://ollama-client.shishirchaurasiya.in/

🔒 隐私政策:https://ollama-client.shishirchaurasiya.in/privacy-policy

🧑💻 GitHub:https://github.com/Shishir435/ollama-client

🐞 错误:https://github.com/Shishir435/ollama-client/issues

🚀 在几秒钟内开始聊天 - 在您自己的机器上进行私密、快速且完全本地的 AI 对话。

专为开发人员、研究人员以及任何重视速度、隐私和离线 AI 控制的人而打造。

#ollama #privacy #olama-client #opensource #offline #ollama-ui #ollamachat #gpt-oss